Seguramente han conocido a alguien en el supermercado que decide escoger unas cuantas naranjas que se encuentran apiladas de manera ordenada en un estante, y al momento de seleccionar aquellas más apetitosas ocurre uno de los momentos más embarazosos de las visitas al supermercado. Me refiero, a ese instante en que se retiran un par de naranjas y la montaña de cítricos colapsa y ruedan vertiginosamente fuera del estante; y, por si fuera poco, intentan volver a colocarlas en su lugar y unas cuantas siguen sin posicionarse de manera ordenada. Si les ha ocurrido este particular fenómeno, entonces han sido testigos de la entropía.

Una anécdota curiosa, relacionada con el significado de la entropía, es cuando Claude E. Shannon desarrolló una ecuación que cuantificaba la información necesaria para transmitir un mensaje. Debido a que su ecuación tenía la misma forma matemática de la entropía, un colega (llamado Jon Von Neumann) le sugiere que nombrara entropía a la ecuación de Shannon, porque siempre tendría la ventaja en un debate ya que nadie sabe que es realmente la entropía. Con esta anécdota en mente, pareciera que se desconoce que es la entropía.

El presente escrito pretende vincular las diferentes acepciones y contextos de la entropía, con la finalidad de tener un concepto unificado con el que al fin podrás decirle a todos en el supermercado “No soy yo quien tiró las naranjas, fue la entropía”.

El origen. La entropía termodinámica

La energía no se crea ni se destruye, sólo se transforma. Es la frase característica de la ley de conservación de la energía. Ese enunciado implica que la misma cantidad de energía “que entra”, es la misma cantidad de energía “que sale”. Por ejemplo, un vehículo requiere gasolina para provocar un proceso de combustión, por lo que la energía ingresa al vehículo en forma de gasolina (energía potencial) la cual, a través de un proceso de combustión, se manifiesta en forma de electricidad o desplazamiento del vehículo.

En el ejemplo anterior pareciera que todo funciona de esa manera, y no existe mayor complicación. Sin embargo, los sistemas reales funcionan de otra forma. Existe un concepto llamado eficiencia (o rendimiento térmico), definido como el cociente entre la energía de salida, y la energía de entrada; si la energía de salida es igual a la energía de entrada, entonces se tiene un proceso con eficiencia perfecta (nada se desperdicia).

En cambio, si la energía de salida es menor que la energía de entrada (como sucede en realidad) se tiene una menor eficiencia, e implica que la energía “se perdió” en algún momento. ¿Qué ocurrió con esa energía? La mayoría de las veces se desprende como calor y es absorbida por los alrededores; por lo que no toda la energía que se ocupa para realizar un trabajo se convierte en energía mecánica. A ese exceso de calor (o energía desperdiciada) se le vinculó con la primera definición de entropía, o entropía termodinámica.

Desorden y la entropía de Gibbs-Boltzmann

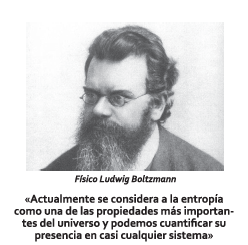

Alrededor de 1870, el extraordinario físico Ludwig Boltzmann propuso la hipótesis de un mundo microscópico a partir del cual era posible deducir todas las propiedades de los objetos macroscópicos.

Para sustentar su hipótesis Boltzmann dedujo una ecuación que vincula la entropía con el número de formas diferentes en que los átomos pueden encontrarse en un sistema termodinámico. A partir de este conjunto de estados probables se puede inferir la existencia de un microestado (un estado que se define por las posiciones y velocidades de cada objeto) con mayor probabilidad de ocurrencia que, a su vez, es la configuración que mejor representa a un sistema.

Willard Gibbs vino a darle mayor peso a la entropía de Boltzmann. Mientras Boltzmann consideraba el conjunto de estados probables para una sola parte del todo, Gibbs pensó en una densidad de distribución que tomaba en cuenta todas las posiciones y velocidades posibles ¡de todos los objetos! A partir de esta función de distribución de densidad se pueden calcular las propiedades termodinámicas de varios sistemas físicos, químicos y biológicos.

Hasta este momento de la historia relatada, la entropía se consideraba como una medida de la energía desperdiciada, vinculada con la transmisión de calor, y ahora se está asociando con una distribución de posiciones y velocidades. Pareciera que la entropía engloba dos conceptos diferentes, pero no es así. Para empatar ambas definiciones de entropía (termodinámica y estadística) vamos a realizar un experimento mental.

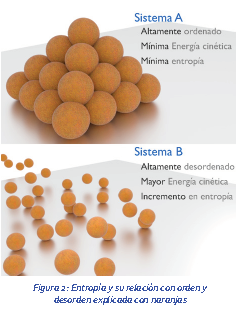

Retomemos el ejemplo del estante con naranjas. Para este caso consideraremos dos estados, el estado A es el estante perfecto, totalmente apilado y ordenado, todas las naranjas están ubicadas espacialmente de manera precisa y su velocidad es cero (ese es su microestado); el estado B es cuando el sistema colapsa y las naranjas ruedan y caen incesantemente, algunas chocan entre sí, y otras salen rodando, por lo que ya tienen velocidad (la cual no es la misma para todas las naranjas), y su ubicación espacial es muy variada.

El estado A (altamente ordenado) tendría una energía cinética mínima o cercana a cero (no hay movimiento) y la entropía es mínima; mientras que el estado B (altamente desordenado) tiene una energía cinética notoria, y ha incrementado su entropía (Figura 2).

Es importante destacar el hecho de que la entropía vincula los conceptos de energía cinética y probabilidad con desorden; y es a partir de aquí que, coloquialmente, la entropía se considera como una medida del desorden.

Incertidumbre, información y la entropía de Shannon

En 1948 surgió una teoría que cambiaría el mundo de la ciencia y la tecnología, el matemático Claude E. Shannon desarrolló “la Teoría de la Información”.

Shannon deseaba encontrar una manera de cuantificar la cantidad de información que podía transmitirse en un mensaje, a través de un cierto canal. Para sorpresa de algunos, la medida propuesta por Shannon tenía la misma forma que la entropía de Gibbs-Boltzmann, la gran diferencia radica en que la entropía de Shannon es una teoría de carácter general que va más allá de la física, y es aplicable a cualquier sistema basado en probabilidades.

En líneas anteriores se esclareció que la entropía está asociada con las probabilidades, el calor y el desorden de los sistemas físicos. Un sistema que genera calor tiene mayor movimiento interno y mayor desorden, por lo que la cantidad de estados probables aumenta y el sistema tiene mayor entropía. La pregunta es ¿Cómo encaja este concepto de entropía con la información y porqué la entropía de Shannon es capaz de aplicarse a tantos campos?

Conceptualmente no difiere mucho la entropía de Shannon con la entropía de Gibbs-Boltzmann y la entropía termodinámica. La entropía de Shannon surge como una medida de información partiendo de la incertidumbre y las probabilidades.

Cuando se tiene un sistema basado en probabilidades se puede inferir su grado de incertidumbre; por ejemplo, si se tiene una serie de eventos que sean todos probables (como lanzar un dado de seis caras), por obvias razones no sabríamos cual de todos los eventos ocurrirá, por lo que se tiene una incertidumbre máxima (mayor entropía) sobre ese sistema probabilístico. En cambio, si conocemos de antemano que eventos ocurrirán, la incertidumbre es nula debido al grado de certeza que tenemos sobre el sistema (entropía mínima).

Aquí viene lo interesante, si retomamos el ejemplo de las naranjas y quisiéramos seleccionar una naranja en específico del estado A (altamente ordenado) tendríamos una mayor probabilidad de localizar esa naranja sin tanto esfuerzo y la incertidumbre sería mínima, provocando un estado de baja entropía; en cambio, el estado B, por ser altamente desordenado, provoca que nuestra incertidumbre sobre la localización de las naranjas sea elevada, y eso se traduce en una entropía elevada.

Con la entropía de Shannon podemos abordar cualquier tipo de sistema basado en probabilidades, por lo que su significado se vuelve más general y de mayor alcance. Dicho de otra forma, si un sistema, objeto o actividad tiene varios resultados posibles (como las apuestas, los servicios de mensajería, el clima, los deportes, el movimiento de los átomos y astros, la mecánica de los electrones y muchos ejemplos más) podemos medir su grado de incertidumbre y, por lo tanto, podemos conocer su entropía.

Vedral, V. (2011). Descodificando la realidad: el universo como información cuántica. Biblioteca Buridán, 2011. (ISBN 9788492616930)

Cercignani, C. (2006). Ludwing Boltzmann: the man who trusted atoms. Oxford University Press, 2006. ISBN 9780191606984.

Moyocoyani Molina Espíritu. Doctor en Química Cuántica, trabaja como Data Scientist en OCC Mundial (México), en el área de Data Strategy & Artificial Intelligence.

Esta dirección de correo electrónico está siendo protegida contra los robots de spam. Necesita tener JavaScript habilitado para poder verlo.